Pernah membuat model machine learning dengan akurasi tinggi, tapi ternyata gagal saat diterapkan ke data baru? Bisa jadi, masalahnya bukan pada algoritma, tapi pada cara kamu mengevaluasi performanya. Di sinilah cross validation berperan penting sebagai teknik untuk mengukur seberapa konsisten model bekerja di luar data pelatihan.

Apa Itu Cross Validation dan Mengapa Penting?

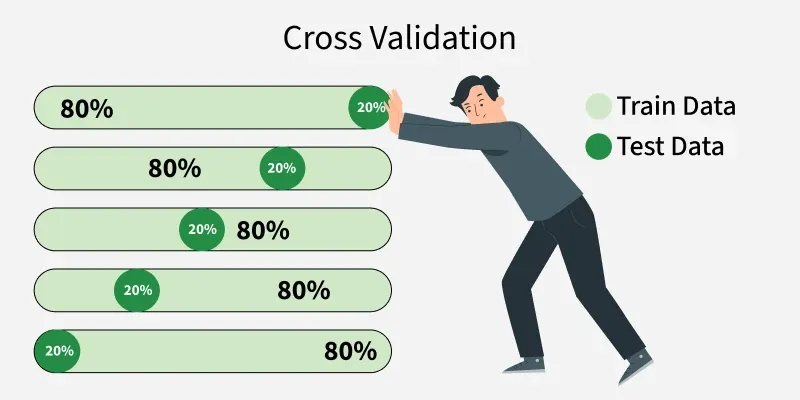

Cross validation adalah metode statistik untuk mengevaluasi performa model dengan membaginya ke dalam beberapa subset data (fold). Model dilatih dan diuji beberapa kali menggunakan kombinasi data yang berbeda, sehingga kamu bisa mendapatkan estimasi performa yang lebih stabil dan tidak bias.

Berbeda dengan pembagian data train-test tunggal yang rawan bias karena ketergantungan pada split tertentu, validasi silang memberikan gambaran menyeluruh tentang seberapa baik model bisa menggeneralisasi ke data baru.

Contoh paling umum adalah k-fold cross validation, di mana data dibagi menjadi k bagian (misalnya 5 atau 10), dan proses pelatihan dan pengujian dilakukan sebanyak k kali dengan bagian yang berbeda-beda.

Manfaat dan Penerapan Cross Validation

Menggunakan cross validation punya banyak keuntungan:

- Mengurangi risiko overfitting, karena evaluasi dilakukan di banyak subset data.

- Memberikan estimasi performa yang lebih akurat dibandingkan metode split biasa.

- Membantu dalam pemilihan model atau parameter (tuning) dengan lebih percaya diri.

- Wajib dalam pipeline analisis prediktif untuk hasil yang bisa diandalkan.

Teknik ini sangat relevan untuk berbagai tugas machine learning—baik klasifikasi, regresi, maupun pembelajaran dengan data kecil. Library populer seperti Scikit-learn menyediakan berbagai fungsi cross validation, mulai dari cross_val_score hingga GridSearchCV.

Terapkan Sekarang, Dapatkan Model yang Andal

Jangan hanya mengandalkan pembagian train-test konvensional. Mulai terapkan teknik validasi silang dalam pipeline machine learning kamu agar bisa yakin bahwa model yang dibangun benar-benar tangguh di dunia nyata. Dengan pendekatan ini, kamu dapat mendeteksi overfitting lebih awal, membandingkan performa berbagai algoritma secara objektif, serta memperoleh estimasi akurasi yang lebih stabil dan dapat dipercaya di berbagai skenario data.

Coba eksperimen dengan berbagai nilai k pada k-fold cross validation, atau gunakan teknik lain seperti stratified k-fold untuk dataset tak seimbang. Langkah kecil ini bisa membuat perbedaan besar pada kualitas prediksi dan keputusan berbasis data.

Kesimpulan:

Cross validation bukan sekadar teknik tambahan, melainkan pondasi untuk memastikan bahwa model prediktif yang kamu bangun benar-benar bisa diandalkan. Dengan memvalidasi model secara menyeluruh, kamu tidak hanya meningkatkan akurasi, tetapi juga membangun kepercayaan terhadap hasil analisis data yang digunakan untuk pengambilan keputusan bisnis, riset, maupun implementasi machine learning.

Masih bingung memilih metode validasi yang tepat atau ingin memastikan modelmu tidak overfitting?

STISID.com siap bantu kamu! Dapatkan konsultasi profesional tentang validasi data, pemodelan prediktif, dan strategi analisis lainnya.

Baca juga : Validasi Data: Langkah Wajib Sebelum Olah dan Analisis

Leave a Reply